Sprachassistenten und UX?

Hintergrund

Seit Februar 2017 kann in Deutschland jeder den stationären intelligenten Sprachassistenten von Amazon erwerben: Amazon Echo, bzw. Alexa. Dies ist ein weiteres Indiz dafür, dass die Verbreitung und Nutzung von Sprachassistenten in Zukunft steigen wird. Eine Studie von Voicelabs prognostiziert für das Jahr 2017 den Verkauf von 24,5 Millionen "Voice-First" Geräten - verglichen mit ca. 5 Millionen verkauften Geräten im Jahr 2016 ist das ein enormer Anstieg.

In eine ähnliche Richtung deutet die Entwicklung der Anzahl an verfügbaren Skills für Amazon Echo. In der zweiten Jahreshälfte von 2016 ist die Anzahl über 500% auf 7000 verfügbare Skills gestiegen.

Sprachassistenten werden unter anderen von Amazon (Alexa), Apple (Siri), Google (Google Now/Assistant), und Microsoft (Cortana) angeboten.

Ungeachtet der steigenden Verbreitung ist ein für den nachhaltigen Erfolg von Sprachassistenten relevantes Kriterium deren Benutzerfreundlichkeit. Nur wenn die Nutzung des Assistenten eine positive, überzeugen User Experience mit sich bringt, wird sich diese Art des Interfaces langfristig in vielen Bereichen der Interaktion mit digitalen Inhalten durchsetzen.

Bei der Optimierung der User Experience eines Sprachassistenten kann - mit ein paar Ausnahmen2 - auf bewährte Methoden und Vorgehensweisen zurückgegriffen werden. Folglich ist es auch bei der Entwicklung von Sprachassistenten oder deren Anwendungen sinnvoll und notwendig sich am User Centered Design Prozess (UCD) zu orientieren.

Und hier setzt diese Studie an: am ersten Schritt des UCD, der Analyse des Nutzungskontexts.

Fragestellungen und methodisches Vorgehen

Folgende Fragestellungen wurden im Rahmen der Studie bearbeitet:

- Wie und wozu werden intelligente Sprachassistenten wie Amazon Echo eingesetzt (Szenarien, Anwendungen, Nutzungskontexte)?

- Warum werden Sie für diese Szenarien, bzw. in diesen Kontexten eingesetzt, und für/in andere/n nicht?

- Welche Herausforderungen ergeben sich bei der Nutzung im Alltag?

- In welcher Form wirkt sich die Verwendung von Assistenten auf die Art und Intensität der Nutzung von anderen Devices aus?

- In welcher Form wirkt sich die Verwendung von Assistenten auf die Kommunikation mit dem Assistenten und auch mit anderen Menschen aus?

- Gibt es Nutzungsintentionen und Wünsche, die derzeit noch nicht befriedigt werden?

Der Fokus lag dabei auf der Beschreibung und Analyse typischer Nutzungsszenarien und -kontexte. Um dies möglichst valide abzudecken wurde eine ethnografische Studie mit Amazon Echo Nutzern durchgeführt.

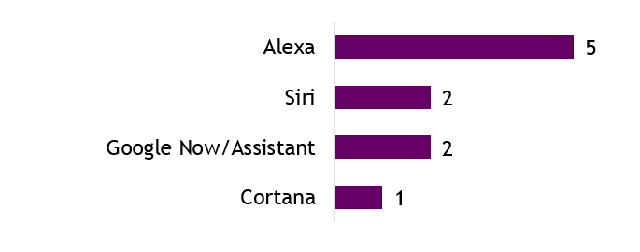

Wir besuchten 5 Haushalte von Amazon Echo Nutzern und konnten so die Nutzung live und im natürlichen Kontext miterleben. Alle 5 Teilnehmer nutzten regelmäßig den Sprachassistenten Alexa, je zwei der Teilnehmer nutzten ergänzend Siri und Google Now/Assistant, und ein Teilnehmer gab an, Cortana in der Arbeit zu nutzen.

Abbildung 2: Alle Teilnehmer nutzten regelmäßig Alexa. Auch weitere Sprachassistenten wurden regelmäßig genutzt.

Typische Nutzungsszenarien mit einem Sprachassistenten

Am häufigsten wird der Sprachassistent für folgende Anwendungsfälle genutzt: Informationssuche (Nachrichten & Wetter), Organisation (Timer, Einkaufs- und Todo-Listen, Kalender), Musik und Smart Home Steuerung (bei Personen, die entsprechende Komponenten besitzen). Es werden also üblicherweise die "Basis-Funktionen" von Alexa genutzt. Ergänzende Skills werden beispielsweise genutzt, um sich ein Taxi zu rufen, nach Kochrezepten zu suchen oder sich über das TV-Programm zu informieren. Diese Anwendungsfälle sind jedoch seltener als die Nutzung der oben genannten "Basis-Funktionen".

Das interessante an einem ethnografischen Vorgehen sind jedoch nicht nur die Ergebnisse über die Nutzungshäufigkeit einzelner Usecases oder Skills. Darüber hinaus kann der Nutzungskontext, also relevante Umgebungsvariablem, der zeitliche Ablauf, etc. betrachtet und analysiert werden. Dies brachte uns folgende Erkenntnisse:

Das Gerät steht meist im Wohnzimmer oder im Flur, so dass es von möglichst vielen Orten innerhalb der Wohnung genutzt werden kann. Der Drang, an möglichst vielen Orten den (stationären) Assistenten zu nutzen führt darüber hinaus dazu, dass …

… Nutzer bewusst Türen offen lassen, um aus dem Nebenraum interagieren zu können.

… weitere Assistenten (z. B. Amazon Echo Dots) angeschafft wurden, oder in naher Zukunft angeschafft werden, um in weiteren Räumen mit dem Assistenten interagieren zu können.

Inwieweit die Nutzung des Assistenten in den Alltag der Nutzer integriert ist, kann pauschal nicht beantwortet werden. Der Grad der Integration in den Alltag ist abhängig vom konkreten Usecase. Die Nutzer beschreiben teilweise Szenarien, die sehr ritualisiert ablaufen. Dabei sind Ablauf, Befehl, Zeitpunkt und Position des Nutzers jeden Tag sehr ähnlich. So wird zum Beispiel das Informieren über das aktuelle Wetter in das morgendliche Ritual nach dem Aufstehen integriert.

Demgegenüber beschreiben die Nutzer auch sehr situative Nutzungsszenarien, beispielsweise vom Timer stellen oder dem Anlegen einer Einkaufsliste. Dieses Usecases werden nur - und dann direkt - bei Bedarf ausgeführt, also beim Kochen oder wenn gerade die letzte Milch aufgebraucht wird. Dabei können sich sowohl der Ablauf, also auch der Befehl oder die Position des Nutzers von Mal zu Mal sehr unterscheiden.

Wann und wofür wird Alexa nicht genutzt?

Um anhand einer Kontextanalyse hilfreiches Wissen bezüglich der Anforderungsspezifikation und der Gestaltung eines Interfaces zu generieren, ist es neben der Analyse der Nutzungsszenarien auch relevant, die Szenarien zu betrachten, in denen der Assistent nicht genutzt wird. Wenig überraschend ist diesbezüglich die Erkenntnis, dass der (stationäre) Assistent nicht genutzt wird, wenn der Nutzer außer Haus ist, oder sich in einem Raum ohne Assistent aufhält. Für beide Szenarien sind vor allem mobile Devices, und natürlich auch die entsprechenden Assistenten Siri und Google Now/Assistant relevante Alternativen.

Es gibt jedoch auch Szenarien, in denen Alexa grundsätzlich verfügbar ist, aber dennoch nicht genutzt wird. Als Hauptgrund hierfür nennen die Nutzer eine nicht ausreichende Informationstiefe und Einschränkungen durch den rein akustischen Output. Werden zum Beispiel detailliertere Wetterinformationen für Allergiker oder tiefergehende Nachrichten gesucht, dann wird auf das Smartphone oder ein anderes Device zurückgegriffen. Ebenso beim Thema Smart Home: Während die Steuerung des Smart Homes häufig über den Assistenten stattfindet, so werden Informationen über das Smart Home, beispielsweise über den Stromverbrauch einzelner Verbraucher, eher nicht über das sprachliche Interface abgerufen.

Wie ist die Kommunikation?

Die Nutzer beschreiben die Kommunikation mit den Assistenten eher als nicht natürlich sprachlich. Es kommt keine Konversation zu Stande, und die Befehle sind eher kurze, klare Anweisungen; die Nutzer haben das Gefühl, sie reden mit einer Maschine. Dementsprechend verzichten die meisten Nutzer auf ein "Bitte" oder "Danke", da dies den Assistenten eher noch verwirrt.

Die Kommunikation mit dem Assistenten ist aufgrund drei weiterer Eigenschaften nicht natürlich sprachlich, bzw. sogar ressourcenfordernd. Erstens muss die Redegeschwindigkeit beim Sprechen beachtet werden. Laut den Erfahrungen der Nutzer wird eine zu schnell, oder auch zu langsam gesprochene Anweisung häufig nicht verstanden. Intuitiv ausgesprochene Anweisungen treffen oft die optimale Redegeschwindigkeit nicht, so dass der Nutzer seine natürliche Redegeschwindigkeit anpassen muss. Zweitens muss der Nutzer - bevor er mit dem Assistenten kommuniziert - über den Funktionsumfang und die Fähigkeiten des Assistenten nachdenken: "Kann Alexa überhaupt das, was ich gerade möchte?". Drittens ist die Satzstellung des Befehls entscheidend. Folglich muss sich der Nutzer zusätzlich, idealerweise vor dem Start der Interaktion, über die korrekte Satzstellung Gedanken machen.

Zukunftswünsche der Nutzer

Aufmerksamen Lesern sind bereits zwischen den Zeilen einige - bisher nicht zufriedenstellend befriedigte - Nutzerwünsche aufgefallen. Zum Beispiel der Wunsch nach einer natürlich sprachlicheren Kommunikation mit dem Assistenten, also die Möglichkeit ohne vorheriges Nachdenken Befehle aussprechen zu können.

Oder aber das Bedürfnis im Rahmen gewisser Usescases visuellen Output von dem Assistenten zu bekommen, z. B. beim Abruf von Informationen über das Smart Home.

Aber auch darüber hinaus bekamen wir wünschenswerte Optimierungspotentiale und (Funktions-) Erweiterungen zu hören. Gerade im Zusammenhang mit der Smart Home Steuerung wäre eine noch intelligentere und situationsbezogene Assistenz wünschenswert. Damit ist unter anderem situatives Feedback über gewisse Ereignisse gemeint, z. B. eine Push-Nachricht, wenn der Trockner fertig ist oder die Haustüre zu lange offensteht.

Andere Nutzer wünschen sich eine weitreichendere Integration von Diensten anderer Anbieter, so dass sie ihre lokal erstellten Musik-Playlisten über den Assistenten abspielen können, oder ihren Nicht-Google Kalender über den Assistenten verwalten können. Ergänzend zum Thema Kalender wünschen sich die Teilnehmer auch die Möglichkeit, Kalendereinträge zu priorisieren und Erinnerungen hinzuzufügen.

Auch Anrufe und Sprachnachrichten über den (stationären) Assistenten durchzuführen ist ein Wunsch der Nutzer. Hierfür muss bisher auf einen mobil verfügbaren Assistenten zurückgegriffen werden, der ggf. zunächst aus der Hosen- oder Handtasche herausgeholt werden muss.

Zusammenfassend zeigte sich uns ein Bild von einer heterogenen Nutzerschaft - sowohl hinsichtlich der genutzten Funktionen, als auch hinsichtlich relevanter Kontextvariablen wie Alltags-Integration und Verhaltensänderungen durch den Assistenten. Auch das Ausmaß, wie stark die heutigen Assistenten den Alltag der Nutzer bereits erleichtern, schwankt. Wir hörten Aussagen von "wirklich alltagserleichternd ist der Assistent noch nicht" bis hin zu "durch den Assistenten ist vieles einfacher geworden". Dies zeigt, dass es bei der Entwicklung eines VUI wichtig ist, die Zielgruppe und ihren Nutzungskontext zu kennen.

Sie brauchen weitere Informationen?

Den kompletten Bericht mit Informationen zu

- Änderungen hinsichtlich der Device- und Mediennutzung

- Alltagsprobleme und Lösungsstrategien,

- detaillierten Beschreibungen zum Ablauf einzelner Usecases

schicken wir Ihnen gerne kostenlos zu. Schreiben Sie uns!

Xaver Bodendörfer

- +49 89 38156 4044

- xaver.bodendoerfer(at)eresult.de

Sie wollen den Forschungsbeitrag zitieren? Gerne können Sie folgende Quellenangabe nutzen:

Bodendörfer, Xaver (2017). Digitale Sprachassistenten als intelligente Helfer im Alltag, In: Forschungsbeiträge der eresult GmbH

Das könnte Sie auch interessieren:

- Usability Testing mit Sprachassistenten

- Lieber Assistent, ärgere mich bitte nicht

- Testobjekte: Sprachassistenten und Chatbots

Relevante eresult-Produkte:

- User-Research

- UX Lab